数据中心散热仿真解决方案

2026-1-9 13:28:45 点击:

当AI算力以每年提升三倍的速度狂奔,数据中心的散热系统正面临前所未有的压力,而水这一最传统却又最高效的冷却介质,正成为制约算力发展的关键因素。

2023年,某大型云服务商的欧洲数据中心,因冷却系统故障导致集群宕机12小时,直接损失超过2000万美元。事后调查显示,微小的水垢颗粒堵塞了液冷系统的微通道,引发连锁反应。

与此同时,全球领先的超级计算中心正将单机架功率密度推向100kW—相当于200个传统家庭空调的制冷需求,而这只有通过先进的水冷技术才能实现。

01 数据中心面临的水问题

随着算力需求爆炸式增长,数据中心的功率密度和散热需求,已逼近传统风冷的物理极限,水相关问题从边缘问题升级为核心挑战。

(1) 冷凝之患:湿度控制的精密平衡

数据中心环境控制面临湿度的双重挑战:既要防止过度潮湿导致设备短路,又要避免过度干燥产生静电。

当空气中的水蒸气遇到冰冷的服务器表面时,会形成微米级的冷凝水膜。这些微小的水滴足以引发主板短路、元器件腐蚀和信号干扰。研究表明,数据中心的最佳相对湿度应控制在45%~55%之间。超出这个范围,每偏离10%,设备故障率就会增加1.8~2.3个百分点。

在高温高湿地区,除湿系统能耗可占数据中心总能耗的8%~12%,成为不可忽视的运营成本。

(2) 散热革命:从风冷到液冷的演进

算力密度的提升,正推动散热技术的快速迭代:

传统风冷技术:

适用于功率密度低于15kW/机架的场景,通过机房空调和强制对流进行散热。但当单机架功率超过30kW后,风冷效率急剧下降。

传统水冷体系:

冷却板技术:在服务器级别安装水冷板,直接接触CPU/GPU进行散热;后门热交换器:在机架后门安装水冷热交换器,捕获热空气能量;浸没式冷却:将整个服务器浸入不导电的冷却液中,实现极致散热;

相变冷却进阶:

微通道沸腾冷却:在芯片背面蚀刻微细通道,利用液体相变吸收潜热;直接芯片冷却:冷却液直接流经芯片封装,消除所有界面热阻;

例如,谷歌TPU v4 pods采用全液冷设计,PUE值降至1.1以下,而微软的雅典娜项目实现了单芯片1000W的散热能力。

(3)结冰风险:寒冷环境的特殊挑战

在北方地区或低温环境中,数据中心的冷却系统面临独特的结冰问题:

干冷器结冰:当环境温度低于0°C时,干冷器翅片管上的冷凝水会结冰,增加空气流动阻力,降低散热效率。

管道冻裂风险:冷却水在静止或低速流动状态下,遇冷结冰体积膨胀9%,产生的压力足以使铜管破裂、接头泄漏。

冰堵现象:微冷却通道内局部结冰形成堵塞,导致流量分配不均,引发热点和过热故障。

冬季运行的数据中心需要配备“防冻加热系统和乙二醇混合溶液”,但这些措施又增加了系统的复杂性和能耗。

02 仿真技术:数据中心水问题的数字实验室

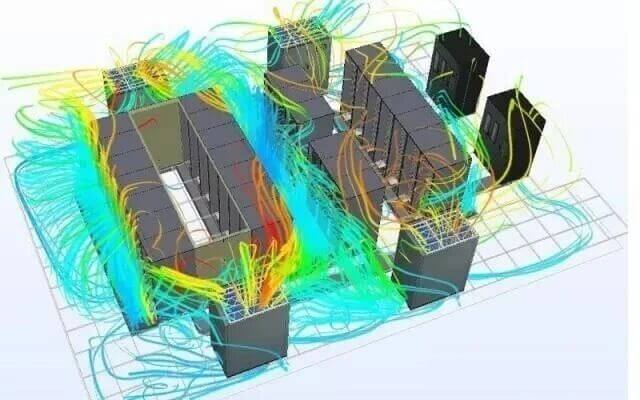

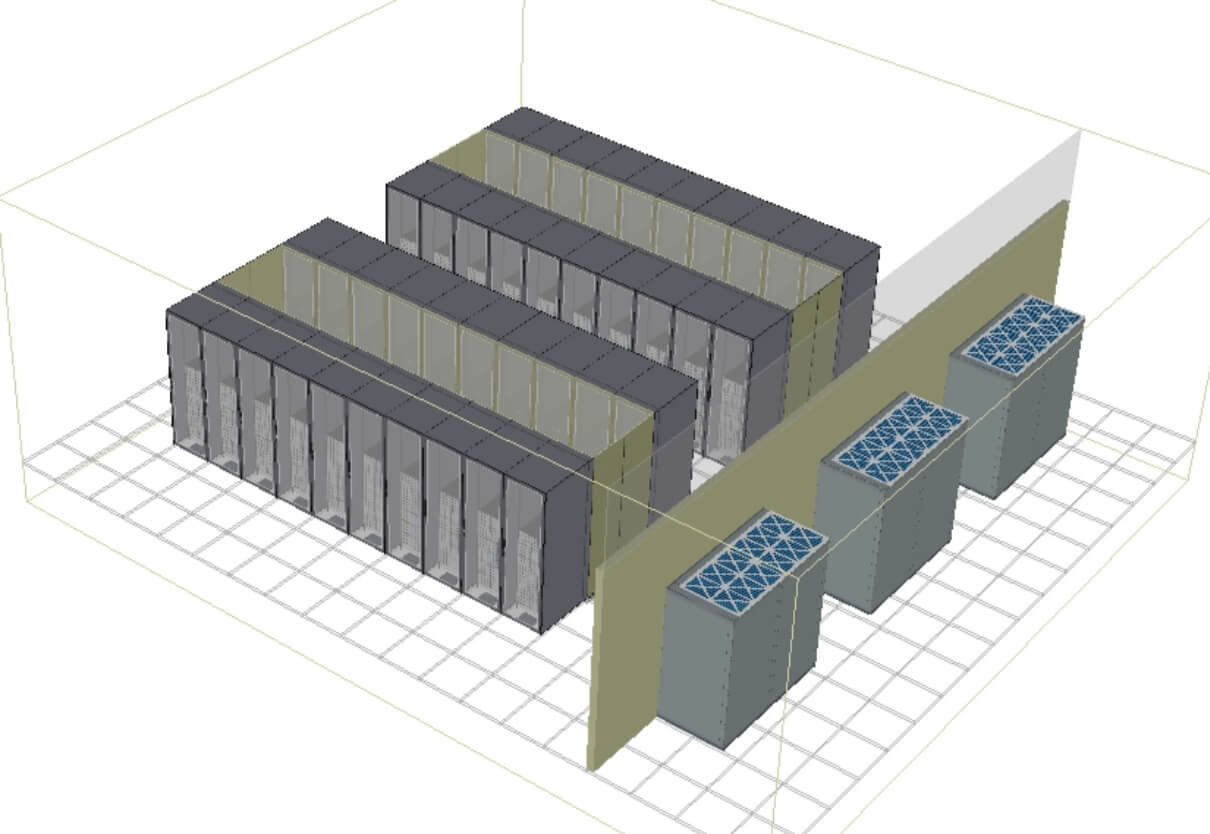

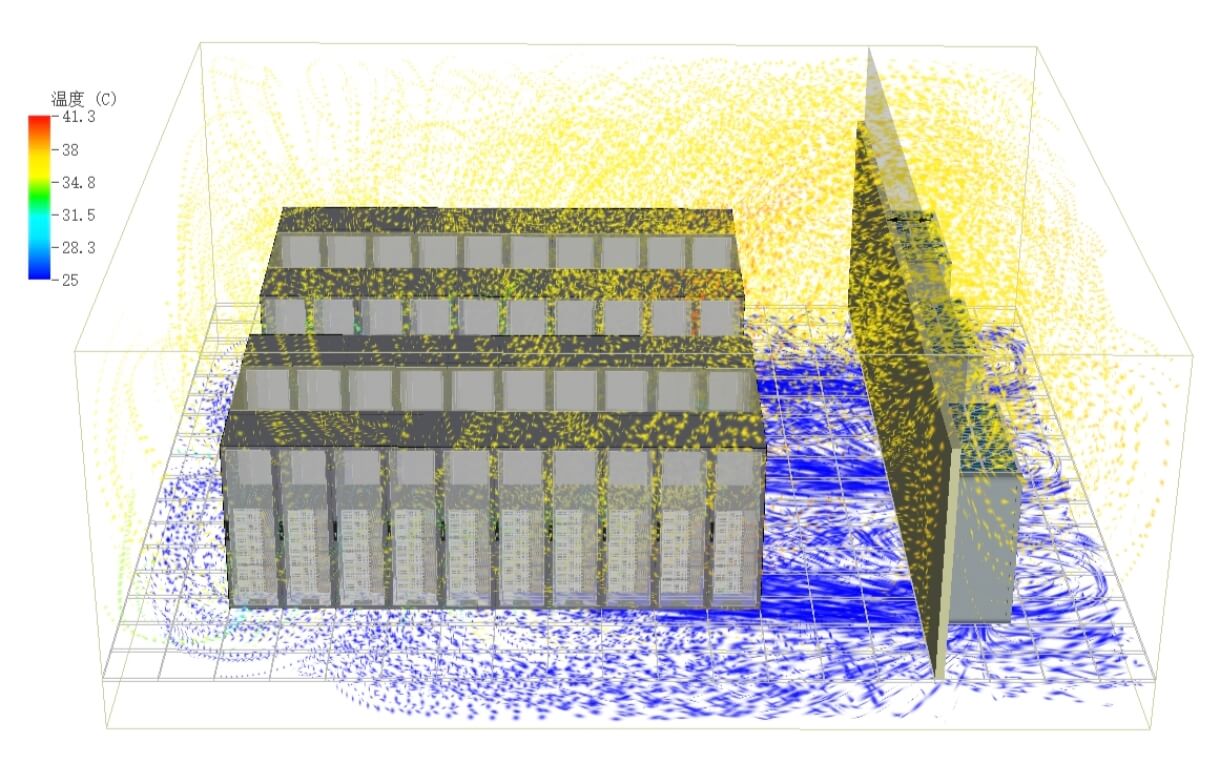

现代仿真技术,为数据中心的水相关问题提供了全方位的分析工具,通过多物理场耦合模拟,实现在虚拟环境中优化设计、预测风险。

(1)两相流与湿度控制仿真

数据中心环境湿度模拟,需要气液两相流与传质耦合分析,主要采用以下方法:

欧拉-欧拉多流体模型:将气相和液相视为相互渗透的连续介质,求解各自的质量、动量和能量方程:

∂(αₖρₖ)/∂t + ∇·(αₖρₖuₖ) = 0

∂(αₖρₖuₖ)/∂t + ∇·(αₖρₖuₖuₖ) = -αₖ∇p + ∇·τₖ + αₖρₖg + Mₖ

其中αₖ为k相体积分数,Mₖ为相同作用力。

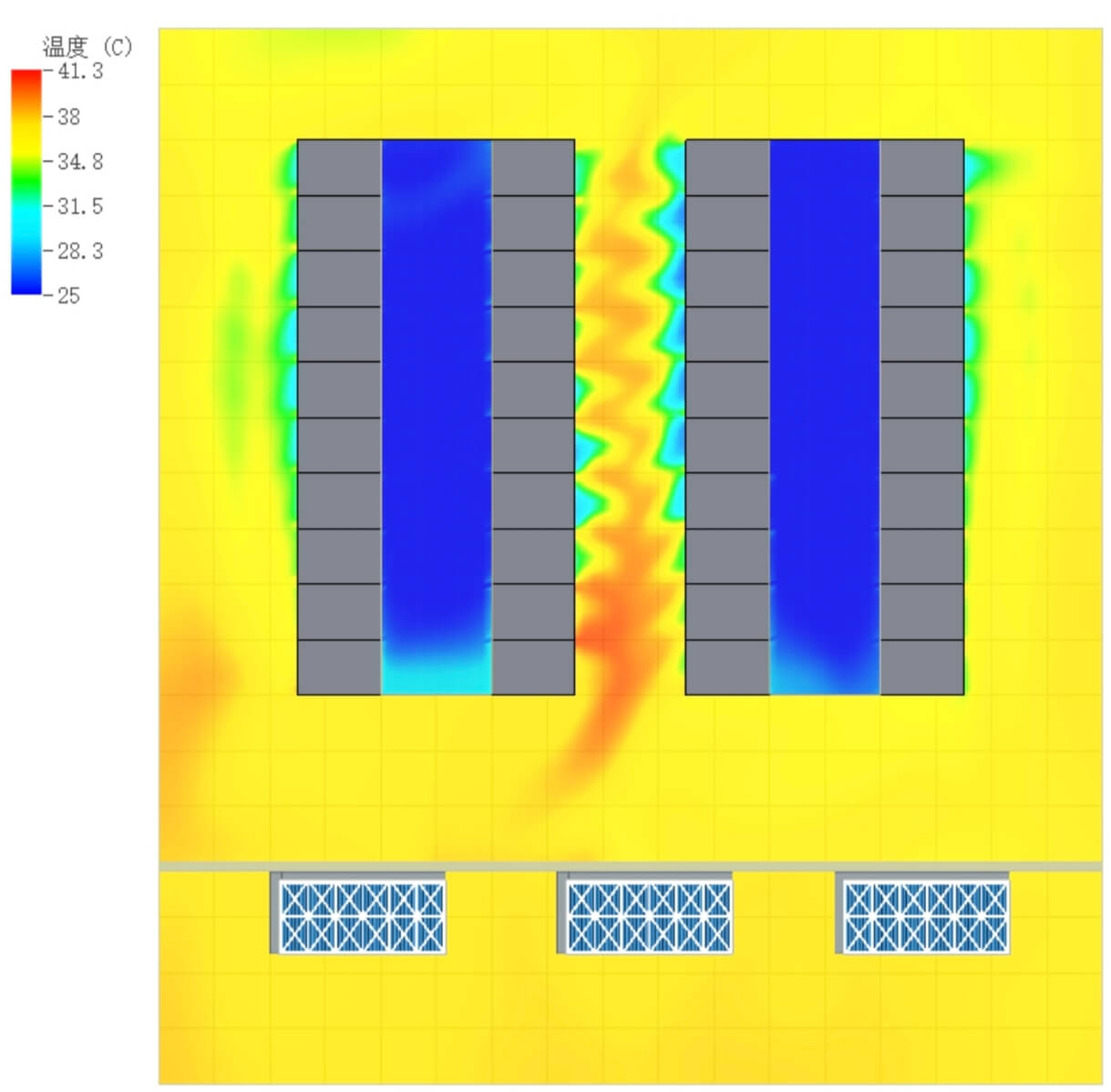

实际工程中,通过“CFD+建筑能耗耦合仿真”,将机房微环境与空调系统动态结合,优化除湿器位置和送风参数,确保湿度均匀分布。

(2) 流体-传热耦合散热仿真

数据中心液冷系统仿真涉及复杂的”三维流固共轭传热“问题,需要同时求解流体域和固体域的耦合方程。

湍流模型选择:

标准k-ε模型:用于机房级别宏观流动模拟;SST k-ω模型:适用于近壁区边界层精确解析;LES大涡模拟:用于瞬态热波动分析;

porous media模型:模拟冷板内部的微通道网络,将详细结构简化为多孔介质,大幅降低计算资源需求:

∇·(ρu) = 0

∂(ρu)/∂t + ∇·(ρuu) = -∇p + ∇·τ - (μ/κ)u

其中κ为渗透率张量,通过达西-福希海默方程描述流动阻力。

对于浸没式冷却,需要多相流与相变耦合,使用VOF(Volume of Fluid)方法追踪气液界面,结合相变模型计算沸腾传热。

(3)液固相变与结冰仿真

数据中心冷却系统的结冰过程,属于移动边界相变问题,主要仿真方法包括:

焓-多孔度方法,通过定义液相分数将相变区域处理为多孔介质:

∂(ρh)/∂t + ∇·(ρuh) = ∇·(k∇T) + Sₕ

Sₕ = - ρL[∂fₗ/∂t + ∇·(ufₗ)]

其中L为潜热,fₗ为液相分数,源项Sₕ处理相变潜热。

相场法,通过引入序参数自然描述固液相界面,避免显式跟踪移动边界:

∂ϕ/∂t = M∇²ψ - M∂f/∂ϕ

ψ = - ε²∇²ϕ + f'(ϕ) - λθ

其中ϕ为相场变量(-1≤ϕ≤1),ε为界面厚度参数,θ为过冷度。

工程应用中,结合系统热惯性与环境气象数据,预测不同气候条件下冷却系统的结冰风险,优化防冻控制策略。

03 AI算力爆发下的水挑战

大模型训练和推理的算力需求正以指数级增长,与之相伴的水相关问题也日益严峻。

(1)散热需求的指数曲线

GPT-4等千亿参数模型的训练,需要上万块GPU连续运行数月,单集群功耗达5~10 MW,相当于一个小型城镇的用电量。

传统风冷技术在30kW/机架以上基本失效,液冷技术从备选项变为必选项。NVIDIA DGX H100系统采用直接芯片冷却,散热能力达700 W/cm²。

超大规模数据中心的日冷却水消耗量已达万吨级,在水资源紧张地区引发可持续性担忧。

(2)水足迹的隐性成本

研究表明,训练一个千亿参数大模型的全生命周期水足迹超过50万升,包括直接冷却用水和间接电力生产用水。

在干旱地区,数据中心用水与农业和居民用水形成竞争关系,Google在亚利桑那州的数据中心,就曾因水资源问题引发社区争议。

04 水问题仿真发展方向

面对日益复杂的数据中心水管理挑战,仿真技术正朝着更高精度、更快速度、更强融合的方向发展。

(1)多尺度一体化仿真平台

未来的仿真系统,需要实现从芯片级到园区级的全尺度覆盖:

芯片-板卡级(微米-厘米):模拟微通道内的流动沸腾和临界热流密度;机架-机房级(米级):分析冷却液分配和热回收系统;数据中心级(十米级):优化水资源综合利用和能源效率;

(2)AI赋能的智能仿真

物理信息神经网络,将控制方程嵌入神经网络约束,实现比传统FEM快100倍的计算速度,特别适合参数化设计和优化。

深度操作网络,学习从设计参数到流场/温度场的映射关系,实现实时性能预测和故障诊断。

数字孪生系统,结合传感器数据,构建冷却系统的虚拟镜像,实现:基于负载预测的动态流量控制;预防性维护和结垢预警;自适应环境变化的防冻保护;

(3)面向新型冷却技术的专用仿真

针对下一代冷却技术,需要发展专门的仿真工具:

微流体冷却仿真:分析100微米级通道内的电润湿效应和毛细流动;纳米流体强化传热:研究纳米颗粒对对流换热的增强机制和稳定性;两相浸没冷却:模拟池沸腾过程中的气泡动力学和临界热流密度;

可持续水管理仿真,将冷却系统与水处理、雨水收集结合,实现水资源的闭环管理,最大限度减少新鲜水消耗。

05 展望

在算力即生产力的时代,数据中心的散热能力,直接决定了计算能力的上限。水作为最古老却又最高效的冷却介质,正在算力基础设施中扮演着越来越关键的角色。

从防止微米级冷凝水导致的服务器短路,到设计兆瓦级液冷系统,再到优化整个数据中心的水资源利用效率,多物理场仿真技术,提供了一个无需昂贵测试的数字实验室。

随着AI算力需求的持续爆发,对水相关问题的深入理解和精确仿真,将变得更为重要。这不仅是技术挑战,也是算力产业可持续发展的关键所在。从一定程度上说,掌控水,就是掌控了算力的未来。

2023年,某大型云服务商的欧洲数据中心,因冷却系统故障导致集群宕机12小时,直接损失超过2000万美元。事后调查显示,微小的水垢颗粒堵塞了液冷系统的微通道,引发连锁反应。

与此同时,全球领先的超级计算中心正将单机架功率密度推向100kW—相当于200个传统家庭空调的制冷需求,而这只有通过先进的水冷技术才能实现。

01 数据中心面临的水问题

随着算力需求爆炸式增长,数据中心的功率密度和散热需求,已逼近传统风冷的物理极限,水相关问题从边缘问题升级为核心挑战。

(1) 冷凝之患:湿度控制的精密平衡

数据中心环境控制面临湿度的双重挑战:既要防止过度潮湿导致设备短路,又要避免过度干燥产生静电。

当空气中的水蒸气遇到冰冷的服务器表面时,会形成微米级的冷凝水膜。这些微小的水滴足以引发主板短路、元器件腐蚀和信号干扰。研究表明,数据中心的最佳相对湿度应控制在45%~55%之间。超出这个范围,每偏离10%,设备故障率就会增加1.8~2.3个百分点。

在高温高湿地区,除湿系统能耗可占数据中心总能耗的8%~12%,成为不可忽视的运营成本。

(2) 散热革命:从风冷到液冷的演进

算力密度的提升,正推动散热技术的快速迭代:

传统风冷技术:

适用于功率密度低于15kW/机架的场景,通过机房空调和强制对流进行散热。但当单机架功率超过30kW后,风冷效率急剧下降。

传统水冷体系:

冷却板技术:在服务器级别安装水冷板,直接接触CPU/GPU进行散热;后门热交换器:在机架后门安装水冷热交换器,捕获热空气能量;浸没式冷却:将整个服务器浸入不导电的冷却液中,实现极致散热;

相变冷却进阶:

微通道沸腾冷却:在芯片背面蚀刻微细通道,利用液体相变吸收潜热;直接芯片冷却:冷却液直接流经芯片封装,消除所有界面热阻;

例如,谷歌TPU v4 pods采用全液冷设计,PUE值降至1.1以下,而微软的雅典娜项目实现了单芯片1000W的散热能力。

(3)结冰风险:寒冷环境的特殊挑战

在北方地区或低温环境中,数据中心的冷却系统面临独特的结冰问题:

干冷器结冰:当环境温度低于0°C时,干冷器翅片管上的冷凝水会结冰,增加空气流动阻力,降低散热效率。

管道冻裂风险:冷却水在静止或低速流动状态下,遇冷结冰体积膨胀9%,产生的压力足以使铜管破裂、接头泄漏。

冰堵现象:微冷却通道内局部结冰形成堵塞,导致流量分配不均,引发热点和过热故障。

冬季运行的数据中心需要配备“防冻加热系统和乙二醇混合溶液”,但这些措施又增加了系统的复杂性和能耗。

02 仿真技术:数据中心水问题的数字实验室

现代仿真技术,为数据中心的水相关问题提供了全方位的分析工具,通过多物理场耦合模拟,实现在虚拟环境中优化设计、预测风险。

(1)两相流与湿度控制仿真

数据中心环境湿度模拟,需要气液两相流与传质耦合分析,主要采用以下方法:

欧拉-欧拉多流体模型:将气相和液相视为相互渗透的连续介质,求解各自的质量、动量和能量方程:

∂(αₖρₖ)/∂t + ∇·(αₖρₖuₖ) = 0

∂(αₖρₖuₖ)/∂t + ∇·(αₖρₖuₖuₖ) = -αₖ∇p + ∇·τₖ + αₖρₖg + Mₖ

其中αₖ为k相体积分数,Mₖ为相同作用力。

实际工程中,通过“CFD+建筑能耗耦合仿真”,将机房微环境与空调系统动态结合,优化除湿器位置和送风参数,确保湿度均匀分布。

(2) 流体-传热耦合散热仿真

数据中心液冷系统仿真涉及复杂的”三维流固共轭传热“问题,需要同时求解流体域和固体域的耦合方程。

湍流模型选择:

标准k-ε模型:用于机房级别宏观流动模拟;SST k-ω模型:适用于近壁区边界层精确解析;LES大涡模拟:用于瞬态热波动分析;

porous media模型:模拟冷板内部的微通道网络,将详细结构简化为多孔介质,大幅降低计算资源需求:

∇·(ρu) = 0

∂(ρu)/∂t + ∇·(ρuu) = -∇p + ∇·τ - (μ/κ)u

其中κ为渗透率张量,通过达西-福希海默方程描述流动阻力。

对于浸没式冷却,需要多相流与相变耦合,使用VOF(Volume of Fluid)方法追踪气液界面,结合相变模型计算沸腾传热。

(3)液固相变与结冰仿真

数据中心冷却系统的结冰过程,属于移动边界相变问题,主要仿真方法包括:

焓-多孔度方法,通过定义液相分数将相变区域处理为多孔介质:

∂(ρh)/∂t + ∇·(ρuh) = ∇·(k∇T) + Sₕ

Sₕ = - ρL[∂fₗ/∂t + ∇·(ufₗ)]

其中L为潜热,fₗ为液相分数,源项Sₕ处理相变潜热。

相场法,通过引入序参数自然描述固液相界面,避免显式跟踪移动边界:

∂ϕ/∂t = M∇²ψ - M∂f/∂ϕ

ψ = - ε²∇²ϕ + f'(ϕ) - λθ

其中ϕ为相场变量(-1≤ϕ≤1),ε为界面厚度参数,θ为过冷度。

工程应用中,结合系统热惯性与环境气象数据,预测不同气候条件下冷却系统的结冰风险,优化防冻控制策略。

03 AI算力爆发下的水挑战

大模型训练和推理的算力需求正以指数级增长,与之相伴的水相关问题也日益严峻。

(1)散热需求的指数曲线

GPT-4等千亿参数模型的训练,需要上万块GPU连续运行数月,单集群功耗达5~10 MW,相当于一个小型城镇的用电量。

传统风冷技术在30kW/机架以上基本失效,液冷技术从备选项变为必选项。NVIDIA DGX H100系统采用直接芯片冷却,散热能力达700 W/cm²。

超大规模数据中心的日冷却水消耗量已达万吨级,在水资源紧张地区引发可持续性担忧。

(2)水足迹的隐性成本

研究表明,训练一个千亿参数大模型的全生命周期水足迹超过50万升,包括直接冷却用水和间接电力生产用水。

在干旱地区,数据中心用水与农业和居民用水形成竞争关系,Google在亚利桑那州的数据中心,就曾因水资源问题引发社区争议。

04 水问题仿真发展方向

面对日益复杂的数据中心水管理挑战,仿真技术正朝着更高精度、更快速度、更强融合的方向发展。

(1)多尺度一体化仿真平台

未来的仿真系统,需要实现从芯片级到园区级的全尺度覆盖:

芯片-板卡级(微米-厘米):模拟微通道内的流动沸腾和临界热流密度;机架-机房级(米级):分析冷却液分配和热回收系统;数据中心级(十米级):优化水资源综合利用和能源效率;

(2)AI赋能的智能仿真

物理信息神经网络,将控制方程嵌入神经网络约束,实现比传统FEM快100倍的计算速度,特别适合参数化设计和优化。

深度操作网络,学习从设计参数到流场/温度场的映射关系,实现实时性能预测和故障诊断。

数字孪生系统,结合传感器数据,构建冷却系统的虚拟镜像,实现:基于负载预测的动态流量控制;预防性维护和结垢预警;自适应环境变化的防冻保护;

(3)面向新型冷却技术的专用仿真

针对下一代冷却技术,需要发展专门的仿真工具:

微流体冷却仿真:分析100微米级通道内的电润湿效应和毛细流动;纳米流体强化传热:研究纳米颗粒对对流换热的增强机制和稳定性;两相浸没冷却:模拟池沸腾过程中的气泡动力学和临界热流密度;

可持续水管理仿真,将冷却系统与水处理、雨水收集结合,实现水资源的闭环管理,最大限度减少新鲜水消耗。

05 展望

在算力即生产力的时代,数据中心的散热能力,直接决定了计算能力的上限。水作为最古老却又最高效的冷却介质,正在算力基础设施中扮演着越来越关键的角色。

从防止微米级冷凝水导致的服务器短路,到设计兆瓦级液冷系统,再到优化整个数据中心的水资源利用效率,多物理场仿真技术,提供了一个无需昂贵测试的数字实验室。

随着AI算力需求的持续爆发,对水相关问题的深入理解和精确仿真,将变得更为重要。这不仅是技术挑战,也是算力产业可持续发展的关键所在。从一定程度上说,掌控水,就是掌控了算力的未来。

- 上一篇:滑动轴承刚度,是旋转机械稳定运行的"隐形骨架",也是工程师手 2026/1/9

- 下一篇:油冷电机仿真全景指南 2026/1/8